La nascita dell’autofocus nella fotografia è strettamente legata alla necessità di ridurre i tempi di messa a fuoco manuale, che fino agli anni ’70 rappresentava un ostacolo significativo per la fotografia dinamica. I primi esperimenti risalgono alla fine degli anni ’60, ma è nel 1977 che la ditta giapponese Konica introduce la Konica C35 AF, considerata la prima fotocamera compatta con autofocus integrato. Questo sistema, tuttavia, era basato su un principio attivo, che utilizzava raggi infrarossi per misurare la distanza dal soggetto. Sebbene innovativo, il metodo attivo presentava limiti evidenti: scarsa precisione in ambienti complessi e impossibilità di funzionare attraverso superfici trasparenti.

Il vero salto tecnologico avviene negli anni ’80 con l’introduzione dei sistemi passivi, che analizzano la luce proveniente dal soggetto. Tra questi, il Phase Detection Autofocus (PDAF) si afferma come la soluzione più rapida e precisa. Il principio ottico alla base del PDAF è semplice ma geniale: la luce che attraversa l’obiettivo viene suddivisa in due fasci, ciascuno diretto verso un sensore dedicato. Confrontando la posizione delle immagini formate da questi fasci, il sistema calcola la differenza di fase e determina non solo se il soggetto è a fuoco, ma anche quanto e in quale direzione spostare la lente per ottenere la nitidezza ottimale. Questo aspetto è cruciale: mentre il Contrast Detection AF deve iterare più volte per trovare il punto di massimo contrasto, il PDAF fornisce immediatamente la direzione e l’entità della correzione.

Il primo utilizzo commerciale del PDAF avviene nel 1985 con la Minolta Maxxum 7000, che inaugura l’era delle reflex autofocus. Tuttavia, è nel 1987 che Canon, con la serie EOS, consolida il concetto introducendo moduli AF dedicati basati su specchi secondari. Questi moduli, collocati nella parte inferiore del corpo macchina, ricevono la luce deviata dallo specchio principale e operano indipendentemente dal sensore di immagine. Tale architettura garantisce velocità e precisione, ma introduce problematiche come il front focus e il back focus, dovuti a disallineamenti tra modulo AF e piano focale del sensore.

Negli anni ’90 e 2000, il PDAF diventa lo standard per le reflex professionali, con evoluzioni significative: aumento dei punti AF, sensori a croce per rilevare la fase in due direzioni, e sistemi predittivi per il tracking dei soggetti in movimento. Tuttavia, il concetto rimane invariato: un modulo separato, otticamente collegato tramite specchi, che calcola la differenza di fase. Questa separazione fisica, se da un lato garantisce prestazioni elevate, dall’altro limita l’uso del PDAF in modalità Live View e video, dove lo specchio è sollevato e il modulo AF non riceve luce.

Il passaggio alle fotocamere mirrorless, a partire dal 2008 con la Panasonic Lumix G1, mette in crisi il paradigma tradizionale. Senza specchio, non è possibile utilizzare moduli AF dedicati. Inizialmente, i produttori adottano il Contrast Detection AF, ma la lentezza di questo sistema rispetto al PDAF diventa evidente, soprattutto per la fotografia sportiva e naturalistica. La soluzione? Integrare il principio del PDAF direttamente sul sensore di immagine, eliminando la necessità di componenti separati. Questo approccio, che vedremo nel dettaglio nel prossimo capitolo, segna una delle più importanti rivoluzioni tecnologiche nella storia della fotografia digitale.

Evoluzione tecnologica e transizione verso il sensore

La transizione dal PDAF tradizionale al Phase Detection on Sensor è il risultato di esigenze pratiche e di innovazioni ingegneristiche. Con l’avvento delle mirrorless, la mancanza di specchio e modulo AF dedicato impone una soluzione integrata. I primi tentativi risalgono al 2010, quando Sony introduce la tecnologia Translucent Mirror con la serie SLT, che utilizza uno specchio semitrasparente per mantenere attivo il modulo PDAF anche in modalità Live View. Sebbene ingegnosa, questa soluzione è solo un ponte verso l’obiettivo finale: eliminare completamente lo specchio.

Il vero punto di svolta arriva nel 2012 con Nikon 1 V2 e nel 2013 con Canon EOS 70D, che introduce il celebre Dual Pixel CMOS AF. In questo sistema, ogni pixel del sensore è suddiviso in due fotodiodi, ciascuno ricevente luce da metà dell’apertura dell’obiettivo. Confrontando i segnali dei due fotodiodi, il processore calcola la differenza di fase, replicando il principio ottico del PDAF tradizionale ma direttamente sul piano focale. Questo approccio elimina i problemi di front/back focus, poiché la misurazione avviene sullo stesso piano che registra l’immagine.

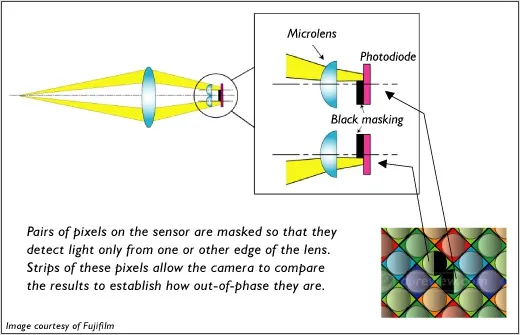

Dal punto di vista tecnico, l’integrazione del PDAF sul sensore richiede soluzioni sofisticate. I pixel dedicati al PDAF devono essere parzialmente mascherati per ricevere luce da direzioni specifiche, senza compromettere eccessivamente la qualità dell’immagine. Le microlenti giocano un ruolo fondamentale nel convogliare la luce verso i fotodiodi corretti. Inoltre, l’algoritmo deve interpolare i dati mancanti nelle aree occupate dai pixel AF, garantendo uniformità cromatica e luminosa.

I vantaggi di questa tecnologia sono evidenti: velocità di messa a fuoco, tracking continuo in modalità video, e compatibilità con funzioni avanzate come il riconoscimento del volto e dell’occhio. Tuttavia, esistono limiti: in condizioni di scarsa illuminazione, la ridotta quantità di luce che raggiunge i fotodiodi PDAF può compromettere la precisione. Per ovviare a questo problema, i produttori hanno sviluppato soluzioni come l’aumento del numero di pixel AF (fino a coprire l’intera superficie del sensore) e l’uso di algoritmi predittivi basati su intelligenza artificiale.

Negli ultimi anni, la tecnologia ha raggiunto livelli impressionanti. Sony con il sistema Fast Hybrid AF, Canon con il Dual Pixel CMOS AF II, e Nikon con il Hybrid AF hanno portato il PDAF su sensore a prestazioni paragonabili, se non superiori, ai moduli dedicati delle reflex. Alcuni sensori moderni, come quelli di OM System e Fujifilm, implementano All-Pixel PDAF, dove ogni pixel contribuisce alla rilevazione di fase, garantendo copertura totale e precisione estrema.

Questa evoluzione non è solo un progresso tecnico, ma un cambiamento di paradigma: il sensore non è più un componente passivo che registra la luce, ma un elemento attivo che partecipa al processo di messa a fuoco. Una trasformazione che ha ridefinito la progettazione delle fotocamere e aperto la strada a nuove possibilità, come la messa a fuoco automatica in fotografia computazionale e nei sistemi di imaging industriale.

Funzionamento tecnico del PDAF su sensore

Il Phase Detection Autofocus su sensore è una tecnologia che combina principi ottici e ingegneria elettronica avanzata per ottenere una messa a fuoco rapida e precisa direttamente sul piano dell’immagine. A differenza del PDAF tradizionale, che utilizza un modulo separato, il sistema on-sensor sfrutta pixel specializzati integrati nel sensore fotografico. Questi pixel non sono identici a quelli dedicati alla cattura dell’immagine: sono progettati per rilevare la differenza di fase tra due fasci di luce provenienti da porzioni opposte dell’apertura dell’obiettivo.

Il processo inizia quando la luce attraversa l’obiettivo e raggiunge il sensore. Alcuni pixel, distribuiti strategicamente sulla superficie del sensore, sono parzialmente mascherati da micro-filtri che consentono loro di ricevere luce da direzioni specifiche. In pratica, ogni pixel PDAF è diviso in due fotodiodi, ciascuno sensibile a metà del cono di luce. Questa separazione permette di ottenere due immagini leggermente sfalsate, analoghe a quelle che si formerebbero in un telemetro ottico. Il processore confronta queste due immagini e calcola la differenza di fase, determinando immediatamente quanto e in quale direzione spostare la lente per raggiungere il fuoco.

Dal punto di vista algoritmico, il calcolo della differenza di fase è complesso. Il sistema deve analizzare migliaia di coppie di fotodiodi, estrarre informazioni di correlazione e stimare il vettore di spostamento. Questo avviene in pochi millisecondi grazie a processori dedicati e algoritmi predittivi. Alcuni produttori, come Canon con il Dual Pixel CMOS AF, hanno perfezionato il sistema al punto che ogni pixel del sensore è un pixel PDAF, garantendo una copertura quasi totale e una precisione elevatissima.

Un aspetto critico è la gestione dei dati mancanti. I pixel PDAF non registrano l’immagine completa, poiché parte della luce è filtrata per la rilevazione di fase. Per evitare artefatti, il processore deve interpolare le informazioni mancanti utilizzando i pixel circostanti. Questo richiede algoritmi sofisticati di ricostruzione, che tengono conto di colore, luminosità e pattern di Bayer.

Le prestazioni del PDAF su sensore sono impressionanti: tempi di messa a fuoco inferiori a 0,05 secondi, tracking continuo di soggetti in movimento e capacità di operare in modalità video senza interruzioni. Tuttavia, esistono limiti. In condizioni di scarsa illuminazione, la ridotta quantità di luce che raggiunge i fotodiodi PDAF può compromettere la precisione. Inoltre, obiettivi con aperture molto ridotte (f/8 o superiori) generano fasci di luce troppo stretti, riducendo l’efficacia del rilevamento di fase.

Per superare questi ostacoli, i produttori hanno introdotto soluzioni come l’aumento del numero di pixel PDAF, la distribuzione uniforme su tutta la superficie del sensore e l’integrazione di algoritmi basati su intelligenza artificiale. Alcuni sensori moderni, come quelli di Sony e Fujifilm, implementano All-Pixel PDAF, dove ogni pixel contribuisce alla rilevazione di fase, eliminando zone cieche e migliorando la precisione in condizioni difficili.

Il funzionamento del PDAF su sensore non è solo una questione di hardware, ma di sinergia tra ottica, elettronica e software. La capacità di calcolare la differenza di fase in tempo reale, correggere la posizione della lente e ricostruire l’immagine senza compromessi rappresenta una delle conquiste più significative nella storia della fotografia digitale.

Innovazioni recenti

Negli ultimi dieci anni, il PDAF su sensore ha conosciuto un’evoluzione rapidissima, spinta dalla competizione tra i principali produttori e dalle esigenze dei fotografi professionisti. Canon, con il suo Dual Pixel CMOS AF introdotto nel 2013, ha aperto la strada a una tecnologia che oggi è considerata uno standard. Ogni pixel del sensore è suddiviso in due fotodiodi, consentendo una copertura quasi totale e una precisione elevata. Questa soluzione ha rivoluzionato la ripresa video, permettendo una messa a fuoco fluida e naturale, simile a quella percepita dall’occhio umano.

Sony ha risposto con il sistema Fast Hybrid AF, che combina PDAF su sensore e contrast detection per garantire prestazioni ottimali in ogni condizione. I sensori Sony di ultima generazione, come quelli montati sulle serie Alpha, offrono fino a 759 punti AF distribuiti su oltre il 90% dell’area del sensore. Questo consente un tracking avanzato, supportato da algoritmi di riconoscimento del volto e dell’occhio basati su intelligenza artificiale.

Nikon, con il suo Hybrid AF, ha adottato una filosofia simile, integrando PDAF e contrast detection per migliorare la precisione in condizioni di scarsa luce. I modelli Z9 e Z8 rappresentano il culmine di questa tecnologia, con capacità di tracking predittivo e messa a fuoco a velocità quasi istantanea.

Le sfide ingegneristiche non sono trascurabili. Integrare pixel PDAF senza compromettere la qualità dell’immagine richiede un design accurato delle microlenti e dei filtri. Inoltre, la gestione termica è critica: sensori ad alta densità di pixel generano calore, che può influire sulla stabilità del segnale. I produttori hanno sviluppato soluzioni come substrati in silicio a bassa resistenza termica e circuiti di dissipazione integrati.

Un’altra sfida è la compatibilità con obiettivi di vecchia generazione. Alcuni obiettivi progettati per reflex non sono ottimizzati per il PDAF su sensore, causando fenomeni di hunting o riduzione della velocità di messa a fuoco. Per ovviare a questo problema, i produttori hanno introdotto adattatori intelligenti con motori di traslazione rapidi e firmware dedicati.

Le innovazioni recenti includono il tracking 3D, che utilizza dati di profondità derivati dalla differenza di fase per prevedere il movimento del soggetto nello spazio. Inoltre, la fotografia computazionale sta integrando il PDAF con algoritmi di fusione multi-frame, migliorando la nitidezza e riducendo il rumore in condizioni estreme.

Il PDAF su sensore non è più una tecnologia confinata alle fotocamere professionali. Oggi è presente negli smartphone di fascia alta, dove sensori miniaturizzati implementano pixel PDAF per garantire una messa a fuoco rapida anche in dispositivi compatti. Questa democratizzazione della tecnologia dimostra la sua versatilità e il ruolo centrale che continuerà a svolgere nell’evoluzione dell’imaging digitale.

Fonti

- https://www.canon-europe.com/technology/dual-pixel-cmos-af/

- https://www.sony.net/Products/di/en-us/technology/fast-hybrid-af.html

- https://www.nikonusa.com/en/learn-and-explore/a/tips-and-techniques/nikon-z-series-autofocus.html

- https://fujifilm-x.com/global/technology/

- https://omsystem.com/technology/

Mi chiamo Marco Adelanti, ho 35 anni e vivo la mia vita tra due grandi passioni: la fotografia e la motocicletta. Viaggiare su due ruote mi ha insegnato a guardare il mondo con occhi più attenti, pronti a cogliere l’attimo, la luce giusta, il dettaglio che racconta una storia. Ho iniziato a fotografare per documentare i miei itinerari, ma col tempo è diventata una vera vocazione, che mi ha portato ad approfondire la storia della fotografia e a studiarne i protagonisti, gli stili e le trasformazioni tecniche. Su storiadellafotografia.com porto una prospettiva dinamica, visiva e concreta: mi piace raccontare l’evoluzione della fotografia come se fosse un viaggio, fatto di tappe, incontri e visioni. Scrivo per chi ama l’immagine come mezzo di scoperta e libertà, proprio come un lungo viaggio su strada.