La distorsione ottica è uno dei difetti più antichi e studiati nella storia della fotografia. Già nel XIX secolo, con l’avvento delle prime fotocamere, i progettisti si trovarono di fronte a un fenomeno che alterava la fedeltà geometrica dell’immagine: linee rette che apparivano curve, proporzioni deformate e prospettive innaturali. Questo problema era legato alla natura stessa delle lenti, superfici curve che devono proiettare un’immagine tridimensionale su un piano bidimensionale. Le prime soluzioni furono di tipo meccanico e ottico, basate sull’uso di combinazioni di lenti simmetriche per compensare le aberrazioni geometriche. Nel 1840, Petzval progettò il celebre obiettivo per ritratti, introducendo schemi ottici che riducevano la distorsione rispetto ai modelli precedenti. Tuttavia, la perfezione era lontana: ogni obiettivo presentava un compromesso tra nitidezza, luminosità e fedeltà geometrica.

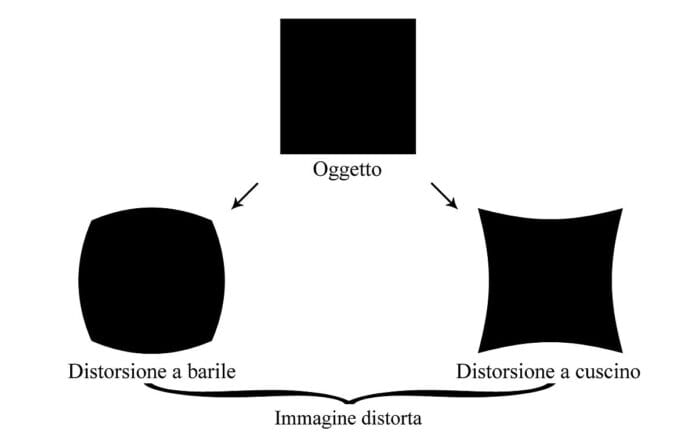

Con l’evoluzione della fotografia nel XX secolo, la distorsione divenne un tema cruciale per applicazioni scientifiche e architettoniche, dove la precisione delle linee era indispensabile. I produttori iniziarono a sviluppare lenti asferiche, capaci di correggere parte delle aberrazioni introdotte dalle superfici sferiche. Questo approccio migliorò la resa, ma non eliminò completamente il problema, soprattutto nei grandangolari e nei teleobiettivi estremi. La distorsione a barilotto, tipica delle focali corte, e quella a cuscinetto, comune nei tele, continuavano a influenzare le immagini. Negli anni ’70, con la diffusione delle reflex 35 mm, la progettazione ottica raggiunse livelli di sofisticazione elevati, ma la correzione rimaneva affidata alla fisica delle lenti.

Il passaggio alla fotografia digitale, negli anni ’90, aprì nuove prospettive. Per la prima volta, la correzione non doveva avvenire esclusivamente in fase di progettazione ottica: era possibile intervenire sull’immagine acquisita, sfruttando algoritmi di elaborazione. Questa rivoluzione concettuale portò alla nascita dei primi software di post-produzione capaci di correggere la distorsione, come Adobe Photoshop, che introdusse il filtro “Lens Correction” basato su profili obiettivo. Tuttavia, questa soluzione richiedeva un intervento manuale e non era integrata nel processo di scatto. Il fotografo doveva conoscere il difetto e correggerlo in fase di editing, con tempi e competenze aggiuntive.

La vera svolta arrivò con le fotocamere digitali di fascia alta, che iniziarono a incorporare sistemi di compensazione automatica. L’idea era semplice ma rivoluzionaria: utilizzare i metadati EXIF per identificare l’obiettivo montato e applicare una correzione geometrica in tempo reale, direttamente nel processore della fotocamera. Questo approccio trasformò la gestione della distorsione da operazione post-scatto a funzione integrata nel flusso di acquisizione, riducendo l’impatto sul workflow e garantendo immagini pronte all’uso. I primi esperimenti risalgono ai primi anni 2000, con modelli di Nikon e Canon che implementavano correzioni di vignettatura e aberrazione cromatica, seguiti dalla distorsione ottica. Da quel momento, la compensazione divenne parte integrante della progettazione delle fotocamere digitali.

Evoluzione verso il sistema integrato e algoritmi di correzione

Il concetto di sistema integrato per la compensazione della distorsione si è sviluppato parallelamente all’avanzamento dei processori di immagine e degli algoritmi di calcolo. Le fotocamere moderne non si limitano a registrare la luce: sono veri e propri computer ottimizzati per elaborare dati in tempo reale. La correzione della distorsione avviene attraverso una sequenza di operazioni matematiche basate su modelli di proiezione. Il principio è quello di mappare i pixel dell’immagine acquisita su una griglia corretta, compensando le deformazioni introdotte dall’obiettivo. Questo processo richiede la conoscenza precisa delle caratteristiche ottiche, motivo per cui i produttori hanno sviluppato profili obiettivo integrati nel firmware.

Gli algoritmi più diffusi si basano su modelli polinomiali che descrivono la distorsione radiale e tangenziale. La distorsione radiale, responsabile delle deformazioni a barilotto e a cuscinetto, viene corretta applicando una funzione inversa che ridistribuisce i pixel verso il centro o verso i bordi. La distorsione tangenziale, meno comune ma presente in obiettivi decentrati, richiede correzioni basate su parametri di inclinazione. Questi calcoli devono essere eseguiti con estrema rapidità per non rallentare il flusso di scatto, soprattutto nelle raffiche ad alta velocità. Per questo motivo, i produttori hanno integrato unità di elaborazione dedicate nei processori d’immagine, capaci di gestire la compensazione senza ridurre il frame rate.

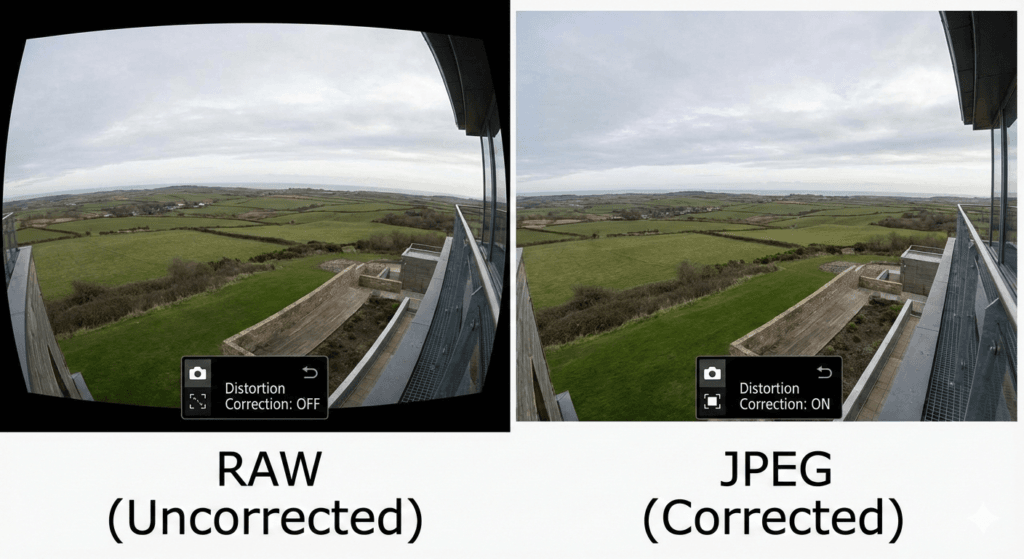

Un aspetto interessante è la sinergia tra hardware e software. Alcuni sistemi, come quelli di Canon e Nikon, applicano la correzione direttamente al file JPEG, mentre lasciano il RAW invariato, consentendo al fotografo di scegliere se utilizzare la versione corretta o intervenire manualmente in post-produzione. Altri marchi, come Sony e Fujifilm, offrono profili di correzione anche nei software di sviluppo RAW, garantendo coerenza tra fotocamera e computer. Questa integrazione ha reso la compensazione della distorsione una funzione trasparente per l’utente, che spesso non si accorge dell’elaborazione in corso.

Dal punto di vista storico, il primo sistema integrato di correzione distorsione è attribuito a Panasonic, che nel 2008 introdusse questa funzione nelle sue mirrorless Micro Quattro Terzi. Canon e Nikon seguirono con implementazioni più sofisticate, estendendo la correzione anche alla vignettatura e all’aberrazione cromatica. Oggi, tutti i principali produttori offrono sistemi di compensazione integrata, con algoritmi sempre più complessi che tengono conto non solo della lunghezza focale, ma anche della distanza di messa a fuoco e dell’apertura del diaframma. Questo livello di dettaglio è possibile grazie alla comunicazione elettronica tra obiettivo e corpo macchina, che trasmette parametri in tempo reale attraverso i contatti elettrici.

La compensazione integrata non è priva di sfide. Il primo problema è la precisione geometrica: una correzione eccessiva può introdurre artefatti, come pixel stirati o perdita di nitidezza ai bordi. Per minimizzare questi effetti, gli algoritmi utilizzano tecniche di interpolazione avanzata, come il bicubico adattivo, che preserva la qualità dell’immagine. Il secondo problema è il consumo energetico, poiché la correzione richiede potenza di calcolo. I processori moderni, come il DIGIC di Canon o l’Expeed di Nikon, sono progettati per gestire queste operazioni senza compromettere l’autonomia, ma il bilancio tra prestazioni e durata della batteria rimane un tema aperto.

L’evoluzione verso il sistema integrato ha trasformato la progettazione ottica. Gli obiettivi moderni non devono più essere perfetti dal punto di vista geometrico: possono privilegiare compattezza e luminosità, delegando la correzione alla fotocamera. Questo approccio ha permesso di ridurre le dimensioni delle ottiche e di ampliare la gamma di zoom ad alte prestazioni, mantenendo una qualità d’immagine elevata grazie alla compensazione digitale. In prospettiva, la correzione integrata continuerà a evolversi, sfruttando algoritmi basati su intelligenza artificiale per adattare la compensazione alle caratteristiche della scena, ma questa è una storia che merita un capitolo dedicato.

Protocolli di integrazione tra obiettivo e corpo macchina

La compensazione della distorsione non è un’operazione isolata, ma il risultato di una stretta collaborazione tra obiettivo e corpo macchina, resa possibile da protocolli di comunicazione elettronica sempre più sofisticati. Nei sistemi reflex tradizionali, il dialogo tra i due componenti era limitato a informazioni meccaniche, come la posizione del diaframma o la distanza di messa a fuoco. Con l’avvento delle fotocamere digitali e delle mirrorless, questa interazione è diventata un flusso di dati complesso, che include parametri ottici, profili di correzione e istruzioni per l’elaborazione in tempo reale.

Il principio alla base di questa integrazione è la trasmissione di metadati attraverso i contatti elettrici dell’innesto. Quando l’obiettivo viene montato, comunica al corpo macchina il proprio ID, la lunghezza focale, l’apertura massima e, nei modelli più avanzati, una serie di coefficienti che descrivono la distorsione a diverse distanze di messa a fuoco. Questi dati sono memorizzati in tabelle interne, che il processore della fotocamera utilizza per applicare la correzione geometrica. Nei sistemi più evoluti, come quelli di Canon RF e Nikon Z, la comunicazione è bidirezionale: il corpo macchina invia comandi per aggiornare il firmware dell’obiettivo, mentre l’obiettivo fornisce informazioni dinamiche, come la posizione delle lenti durante la messa a fuoco.

Dal punto di vista tecnico, i protocolli di comunicazione si basano su bus seriali proprietari, progettati per garantire velocità e affidabilità. La correzione della distorsione richiede tempi di elaborazione ridotti, soprattutto nelle raffiche ad alta velocità, dove ogni millisecondo è cruciale. Per questo motivo, i produttori hanno sviluppato sistemi di trasmissione ottimizzati, capaci di gestire flussi di dati complessi senza interferire con altre funzioni, come il controllo dell’autofocus o del diaframma. Alcuni marchi, come Sony, hanno introdotto protocolli che supportano anche la trasmissione di profili di correzione aggiornabili, consentendo di migliorare la precisione attraverso aggiornamenti firmware.

Un aspetto interessante è la gestione dei profili obiettivo. Ogni obiettivo è caratterizzato da una curva di distorsione che varia in funzione della lunghezza focale e della distanza di messa a fuoco. Nei sistemi zoom, questa curva è particolarmente complessa, poiché la distorsione cambia in modo non lineare lungo l’escursione focale. Per affrontare questa sfida, i produttori memorizzano nel firmware dell’obiettivo una serie di parametri che descrivono la distorsione in punti chiave, mentre la fotocamera interpola i valori intermedi. Questo approccio consente di applicare correzioni precise senza sovraccaricare la memoria con tabelle eccessivamente dettagliate.

La comunicazione tra obiettivo e corpo macchina non si limita alla fase di scatto. Alcuni sistemi, come quelli di Fujifilm, integrano la correzione anche nella visualizzazione live view e nel mirino elettronico, offrendo al fotografo un’anteprima dell’immagine corretta. Questo richiede una sincronizzazione perfetta tra il flusso video e l’elaborazione geometrica, ottenuta grazie a processori dedicati che operano in parallelo. La complessità di questi protocolli dimostra come la compensazione della distorsione sia diventata una funzione strutturale, che coinvolge hardware, firmware e software in un ecosistema integrato.

Impatto sulla progettazione ottica e sul workflow professionale

L’introduzione della compensazione integrata ha avuto un impatto profondo sulla progettazione degli obiettivi e sul modo di lavorare dei fotografi. In passato, la correzione della distorsione era affidata esclusivamente alla geometria delle lenti, imponendo vincoli severi ai progettisti. Per ottenere una resa perfetta, era necessario utilizzare schemi ottici complessi, con numerosi elementi correttivi, che aumentavano peso, dimensioni e costi. Con la possibilità di delegare parte della correzione alla fotocamera, i progettisti hanno acquisito maggiore libertà, potendo privilegiare compattezza e luminosità senza compromettere la qualità finale.

Questo approccio ha favorito la diffusione di zoom ad ampia escursione, come i 24-240 mm, che sarebbero stati impensabili senza la compensazione digitale. Gli obiettivi moderni possono presentare una distorsione significativa a livello ottico, ma il sistema integrato la corregge in tempo reale, restituendo un’immagine geometrica perfetta. Questo ha ridotto il peso delle ottiche professionali e ha ampliato le possibilità creative, consentendo ai fotografi di lavorare con strumenti più versatili. Tuttavia, questa evoluzione ha sollevato anche questioni critiche, come la dipendenza dal software: un’immagine corretta digitalmente non è mai identica a quella ottenuta con una lente perfetta, e la correzione può introdurre artefatti, soprattutto ai bordi.

Dal punto di vista del workflow, la compensazione integrata ha semplificato il processo di produzione. Il fotografo non deve più preoccuparsi di correggere la distorsione in post-produzione, poiché la fotocamera genera file pronti all’uso. Questo è particolarmente vantaggioso per chi lavora in ambito editoriale o sportivo, dove la rapidità è essenziale. Nei file RAW, la correzione può essere applicata automaticamente dai software di sviluppo, grazie ai profili incorporati nei metadati. Questo garantisce coerenza tra la visione in camera e il risultato finale, riducendo il rischio di errori e accelerando il flusso di lavoro.

L’impatto si estende anche alla percezione della qualità. I fotografi professionisti valutano oggi le ottiche non solo in base alla resa ottica, ma anche alla precisione della correzione digitale. Alcuni preferiscono obiettivi con distorsione minima per ridurre l’intervento software, mentre altri accettano compromessi ottici in cambio di leggerezza e versatilità. Questa dinamica ha influenzato le strategie dei produttori, che investono in algoritmi sempre più sofisticati per garantire una correzione invisibile, preservando la nitidezza e la fedeltà cromatica.

La compensazione integrata ha quindi ridefinito il concetto di qualità fotografica, spostando il baricentro dalla lente al sistema. Oggi, la performance di un obiettivo non dipende solo dalla sua costruzione, ma dalla sinergia con il corpo macchina e dal software che governa la correzione. Questo paradigma ha aperto nuove prospettive per la progettazione e ha trasformato il workflow professionale, rendendo la fotografia digitale un processo in cui ottica e informatica operano come un unico organismo.

Algoritmi avanzati e intelligenza artificiale

L’evoluzione della compensazione della distorsione ha raggiunto un livello in cui gli algoritmi tradizionali, basati su modelli polinomiali e interpolazioni geometriche, non sono più sufficienti per garantire la precisione richiesta dalle fotocamere moderne. Con l’aumento della risoluzione dei sensori e la diffusione di ottiche compatte ad alte prestazioni, la correzione deve essere non solo accurata, ma anche adattiva. Questo ha portato all’introduzione di algoritmi avanzati basati su intelligenza artificiale, capaci di analizzare la scena e applicare correzioni dinamiche in tempo reale.

Il principio di funzionamento di questi algoritmi è radicalmente diverso dai metodi classici. Invece di applicare una funzione inversa predefinita, l’IA utilizza reti neurali convoluzionali addestrate su milioni di immagini per riconoscere pattern di distorsione e correggerli in modo contestuale. Questo significa che la correzione non si limita a ripristinare la geometria ideale, ma tiene conto della struttura della scena, evitando di deformare elementi critici come volti o testi. Alcuni produttori, come Sony e Canon, hanno iniziato a integrare modelli di machine learning nei processori d’immagine, sfruttando la potenza di calcolo per ottimizzare la resa senza compromettere la velocità di scatto.

Un vantaggio significativo dell’approccio basato su IA è la capacità di gestire distorsioni complesse, come quelle introdotte da obiettivi decentrabili o da schemi ottici estremi. Nei grandangolari spinti, la distorsione non è uniforme e varia in funzione della prospettiva. Gli algoritmi tradizionali applicano correzioni globali, che possono generare artefatti ai bordi. L’IA, invece, segmenta l’immagine in regioni e applica correzioni locali, preservando la naturalezza delle proporzioni. Questo è particolarmente utile nella fotografia architettonica, dove la fedeltà delle linee è essenziale.

Dal punto di vista tecnico, l’integrazione dell’IA richiede hardware dedicato, come unità di elaborazione neurale (NPU) presenti nei processori di ultima generazione. Questi componenti consentono di eseguire inferenze in tempo reale, riducendo la latenza e mantenendo il flusso operativo fluido. La sfida principale è bilanciare la complessità del modello con il consumo energetico, poiché le fotocamere devono operare in modo efficiente anche in sessioni prolungate. Per questo motivo, i produttori adottano modelli ottimizzati, con architetture leggere che garantiscono prestazioni elevate senza sacrificare l’autonomia.

Un aspetto interessante è la possibilità di aggiornare gli algoritmi via firmware, migliorando la precisione nel tempo. Questo approccio trasforma la fotocamera in un sistema evolutivo, capace di adattarsi alle nuove ottiche e alle esigenze del mercato. Alcuni brand offrono persino la possibilità di scaricare profili specifici per obiettivi appena lanciati, integrando la correzione nel workflow senza interventi manuali. Questa dinamica evidenzia come la compensazione della distorsione sia passata da funzione statica a servizio dinamico, governato da software intelligente.

L’uso dell’IA apre anche prospettive creative. In futuro, gli algoritmi potrebbero non solo correggere la distorsione, ma modificarla intenzionalmente per ottenere effetti artistici controllati. Questo scenario, già sperimentato in applicazioni di editing, potrebbe diventare parte integrante della fotocamera, offrendo al fotografo strumenti per personalizzare la resa geometrica in tempo reale. La compensazione della distorsione, da semplice correzione, si trasformerebbe così in un elemento di design visivo, ampliando le possibilità espressive della fotografia digitale.

Sfide tecniche e prospettive di sviluppo

Nonostante i progressi straordinari, la compensazione integrata della distorsione presenta ancora sfide tecniche che i produttori devono affrontare. La prima riguarda la precisione geometrica in contesti ad alta risoluzione. Con sensori da 50 o 100 megapixel, anche minime imperfezioni nella correzione diventano visibili, soprattutto ai bordi dell’immagine. Gli algoritmi devono operare con tolleranze estremamente ridotte, preservando la nitidezza e la fedeltà cromatica. Questo richiede interpolazioni sofisticate e calcoli complessi, che aumentano il carico sul processore e il consumo energetico.

Un’altra sfida è la gestione della latenza. Nelle raffiche ad alta velocità, tipiche della fotografia sportiva, la fotocamera deve elaborare decine di immagini al secondo, applicando correzioni senza rallentare il flusso. Questo impone l’uso di hardware dedicato e di algoritmi ottimizzati, ma anche di strategie di caching e parallelizzazione. Alcuni produttori adottano approcci ibridi, applicando correzioni parziali in tempo reale e rifiniture nei file JPEG finali, per bilanciare prestazioni e qualità.

La compatibilità tra sistemi è un tema cruciale. Ogni produttore utilizza protocolli proprietari e profili obiettivo specifici, creando un ecosistema chiuso che limita l’interoperabilità. Questo è particolarmente problematico per i fotografi che utilizzano ottiche di terze parti, come Sigma o Tamron, che devono sviluppare profili compatibili con i firmware delle fotocamere. Alcuni brand hanno avviato collaborazioni per standardizzare i metadati, ma la strada verso una piena compatibilità è ancora lunga.

Dal punto di vista della progettazione ottica, la compensazione digitale ha ridotto la pressione sui designer, ma ha introdotto nuove responsabilità. Gli obiettivi possono essere più compatti e luminosi, ma devono fornire dati precisi per la correzione. Questo richiede l’integrazione di chip di comunicazione e la calibrazione accurata delle curve di distorsione. La sinergia tra ottica e software è oggi un requisito imprescindibile, che influenza ogni fase del processo produttivo.

Le prospettive di sviluppo sono orientate verso una maggiore intelligenza del sistema. In futuro, la compensazione potrebbe diventare completamente adattiva, basata su analisi semantiche della scena. Gli algoritmi non si limiteranno a correggere la geometria, ma interpreteranno il contenuto, preservando proporzioni critiche e ottimizzando la resa in funzione del soggetto. Questo approccio, già sperimentato nell’elaborazione HDR e nella riduzione del rumore, potrebbe estendersi alla correzione ottica, trasformandola in un processo cognitivo.

Un’altra direzione promettente è l’integrazione con la realtà aumentata. Le fotocamere potrebbero visualizzare in tempo reale l’effetto della correzione nel mirino elettronico, offrendo al fotografo un controllo totale sulla resa geometrica. Questo richiederà display ad alta risoluzione e processori capaci di gestire flussi complessi, ma aprirà nuove possibilità creative e operative. La compensazione della distorsione, da funzione invisibile, diventerà un elemento interattivo, parte integrante dell’esperienza fotografica.

In conclusione, la compensazione integrata è destinata a evolversi verso sistemi sempre più intelligenti e interconnessi, in cui ottica, elettronica e software operano come un unico organismo. Questa trasformazione non riguarda solo la tecnologia, ma il concetto stesso di fotografia, che si sposta dalla riproduzione passiva alla costruzione attiva dell’immagine.

Fonti

- Distorsione in fotografia: cos’è e come gestirla – FotoNerd

- Distorsioni ottiche: una guida completa – Il Mondo delle Reflex

- Distorsione ottica – Wikipedia

- Correzione della distorsione in Photoshop – Adobe Help

- Algoritmi per la correzione di distorsioni – Università di Bologna

- Correggere AC, distorsione e vignettatura – JuzaPhoto

Articolo aggiornato Febbraio 2026

Mi chiamo Marco Adelanti, ho 35 anni e vivo la mia vita tra due grandi passioni: la fotografia e la motocicletta. Viaggiare su due ruote mi ha insegnato a guardare il mondo con occhi più attenti, pronti a cogliere l’attimo, la luce giusta, il dettaglio che racconta una storia. Ho iniziato a fotografare per documentare i miei itinerari, ma col tempo è diventata una vera vocazione, che mi ha portato ad approfondire la storia della fotografia e a studiarne i protagonisti, gli stili e le trasformazioni tecniche. Su storiadellafotografia.com porto una prospettiva dinamica, visiva e concreta: mi piace raccontare l’evoluzione della fotografia come se fosse un viaggio, fatto di tappe, incontri e visioni. Scrivo per chi ama l’immagine come mezzo di scoperta e libertà, proprio come un lungo viaggio su strada.